The Challenge of Scaling to Meet the Demands of Modern AI and Deep Learning

Deep neural networks are rapidly growing in size and complexity, in response to the most pressing challenges in business and research. The computational capacity needed to support today’s modern AI workloads has outpaced traditional data center architectures. Modern techniques that exploit use of model parallelism are colliding with the limits of inter-GPU bandwidth, as developers build increasingly large accelerated computing clusters and push the limits of data center scale. A new approach is needed—one that delivers almost limitless AI computing scale in order to break through the barriers to achieving faster insights.

심층 신경망은 비즈니스 및 연구 분야에서 가장 시급한 과제에 대응하여 규모와 복잡성이 빠르게 증가하고 있습니다. 오늘날의 최신 AI 워크로드를 지원하는 데 필요한 컴퓨팅 용량은 기존 데이터 센터 아키텍처를 능가합니다. 개발자가 점점 더 큰 가속 컴퓨팅 클러스터를 구축하고 데이터 센터 규모의 한계에 도전함에 따라 모델 병렬 처리를 활용하는 최신 기술은 GPU 간 대역폭의 한계와 충돌하고 있습니다. 새로운 접근 방식이 필요합니다. 즉, 더 빠른 통찰력을 얻기 위한 장벽을 허물기 위해 거의 무한한 AI 컴퓨팅 규모를 제공하는 접근 방식이 필요합니다.

Performance to Train the Previously Impossible

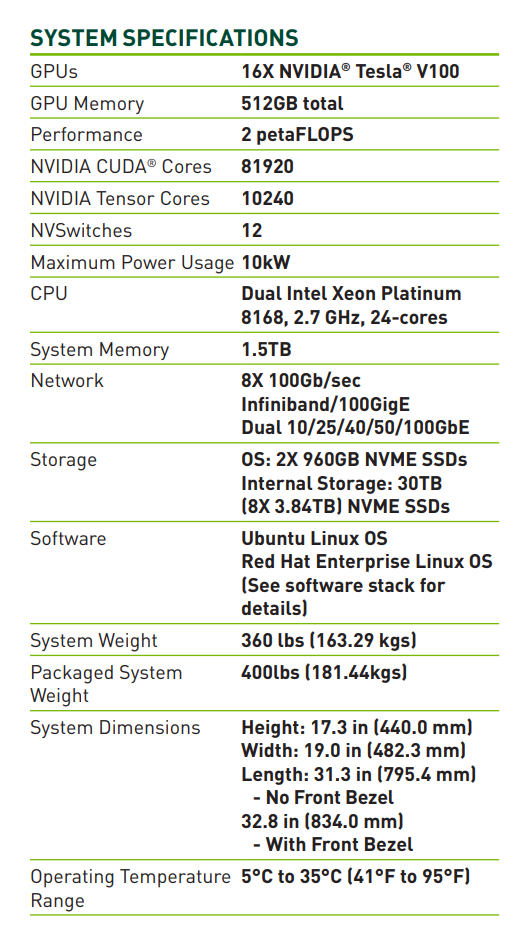

Increasingly complex AI demands unprecedented levels of compute. NVIDIA® DGX-2™ is the world’s first 2 petaFLOPS system, packing the power of 16 of the world’s most advanced GPUs and acelerating the newest deep learning model types that were previously untrainable. With groundbreaking GPU scale, you can train models 4X bigger on a single node. In comparison with legacy x86 architectures, DGX-2’s ability to train ResNet-50 would require the equivalent of 300 servers with dual Intel Xeon Gold CPUs, costing over $2.7 million dollars.

점점 더 복잡해지는 AI는 전례 없는 수준의 컴퓨팅을 요구합니다. NVIDIA® DGX-2™는 세계 최초의 2peta FLOPS 시스템으로, 세계에서 가장 진보된 GPU 16개를 탑재하고 이전에는 훈련할 수 없었던 최신 딥 러닝 모델 유형을 가속화합니다. 획기적인 GPU 확장을 통해 단일 노드에서 4배 더 큰 모델을 훈련할 수 있습니다. 레거시 x86 아키텍처와 비교할 때 ResNet-50을 훈련시키는 DGX-2의 기능은 270만 달러 이상의 비용이 드는 dual Intel Xeon Gold CPU가 장착된 300대의 서버에 해당합니다.

NVIDIA NVSwitch—A Revolutionary AI Network Fabric

Leading-edge research demands the freedom to leverage model parallelism and requires never-before-seen levels of inter-GPU bandwidth. NVIDIA has created NVSwitch to address this need. Like the evolution from dial-up to ultra-high speed broadband, NVSwitch delivers a networking fabric for the future, today. With DGX-2, model complexity and size are no longer constrained by the limits of traditional architectures. Embrace model-parallel training with a networking fabric that delivers 2.4TB/s of bisection bandwidth for a 24X increase over prior generations. This new interconnect “superhighway” enables limitless possibilities for model types that can reap the power of distributed training across 16 GPUs at once.

최첨단 연구는 model parallelism을 활용할 수 있는 자유를 요구하며 이전에는 볼 수 없었던 수준의 GPU 간 대역폭을 요구합니다. NVIDIA는 이러한 요구를 해결하기 위해 NVSwitch를 만들었습니다.dial-up에서 초고속 광대역으로의 진화처럼 NVSwitch는 오늘날 미래를 위한 networking fabric을 제공합니다. DGX-2를 사용하면 모델 복잡성과 크기가 더 이상 기존 아키텍처의 한계에 구속되지 않습니다. 이전 세대에 비해 24배 증가한 2.4TB/s의 이분 대역폭을 제공하는 네트워킹 패브릭으로 모델 병렬 교육을 수용하십시오. 이 새로운 상호 연결 "초고속도로"는 한 번에 16개의 GPU에 걸쳐 분산 교육의 힘을 얻을 수 있는 모델 유형에 대한 무한한 가능성을 가능하게 합니다.

AI Scale on a Whole New Level

Modern enterprises need to rapidly deploy AI power in response to business imperatives and scale-out AI, without scaling-up cost or complexity. We’ve built DGX-2 and powered it with DGX software that enables accelerated deployment and simplified operations— at scale. DGX-2 delivers a ready-to-go solution that offers the fastest path to scaling-up AI, along with virtualization support, to enable you to build your own private enterprise grade AI cloud. Customers can choose to use either pre-installed Ubuntu Linux Host OS, popular among developers, or install Red Hat Enterprise Linux Host OS if IT teams prefer to integrate DGX-2 with their existing Red Hat data center deployment. Now businesses can harness unrestricted AI power in a solution that scales effortlessly with a fraction of the networking infrastructure needed to bind accelerated computing resources together. With an accelerated deployment model, and an architecture purpose-built for ease of scale, your team can spend more time driving insights and less time building infrastructure.

현대 기업은 비용이나 복잡성을 확장하지 않고도 비즈니스 요구 사항에 대응하여 AI 기능을 신속하게 배포하고 AI를 확장해야 합니다. 우리는 DGX-2를 구축했으며 규모에 따라 배포를 가속화하고 운영을 간소화할 수 있는 DGX 소프트웨어를 탑재했습니다. DGX-2는 가상화 지원과 함께 AI를 확장하는 가장 빠른 경로를 제공하여 사설 엔터프라이즈급 AI 클라우드를 구축할 수 있는 즉시 사용 가능한 솔루션을 제공합니다. 고객은 개발자에게 인기 있는 사전 설치된 Ubuntu Linux 호스트 OS를 사용하거나 IT 팀이 기존 Red Hat 데이터 센터 배포와 DGX-2를 통합하는 것을 선호하는 경우 Red Hat Enterprise Linux 호스트 OS를 설치할 수 있습니다. 이제 기업은 가속화된 컴퓨팅 리소스를 함께 묶는 데 필요한 네트워킹 인프라의 일부만으로 손쉽게 확장되는 솔루션에서 무제한 AI 기능을 활용할 수 있습니다. 가속화된 배포 모델과 손쉬운 확장을 위해 특별히 설계된 아키텍처를 통해 팀은 인프라 구축 시간을 줄이고 통찰력을 얻는 데 더 많은 시간을 할애할 수 있습니다.

Access to AI Expertise

With DGX-2, you benefit from NVIDIA’s AI expertise, enterprise-grade support, extensive training, and fieldproven capabilities that can jump-start your work for faster insights. Our dedicated team is ready to get you started with prescriptive guidance, design expertise, and access to our fully-optimized DGX software stack. You get an IT-proven solution, backed by enterprise-grade support, and a team of experts who can help ensure your mission-critical AI applications stay up and running.

'Artificial Intelligence' 카테고리의 다른 글

| GAN(Generative adversarial network) 이란? (0) | 2023.01.07 |

|---|---|

| Top 10 Performance Tuning Practices for Pytorch (0) | 2022.09.21 |

| ImageNet Dataset 압축해제 및 처리 방법 (0) | 2022.08.10 |

| ZeRO-2 & DeepSpeed: Shattering barriers of deep learning speed & scale (0) | 2022.07.29 |

| Inductive Bias란 무엇일까 (0) | 2022.07.27 |