Paper Summary: https://www.marktechpost.com/.../researchers-from.../

Paper: https://arxiv.org/pdf/2112.07945.pdf

Project: https://matthew-a-chan.github.io/EG3D/

Abstract

single-view 2D 사진의 컬렉션만을 사용하여 high-quality multi-view consistent images 및 3D shapes Unsupervised generation 방법은 Long-standing challenge이었습니다. 기존의 3D GANS는 컴퓨팅 집약적이거나 3D 일관성이 없는 근사치를 작성합니다. 전자는 생성 된 이미지의 품질과 해상도를 제한하고 후자는 multi-view consistency and shape quality에 악영향을 미칩니다. 이 작업에서는 이러한 근사치에 지나치게 의존하지 않고 3D GANS의 계산 효율과 이미지 품질을 향상시킵니다. 이러한 목적을 위해, 우리는 다른 디자인 선택과 함께, 고해상도 멀티 뷰 일관성있는 이미지뿐만 아니라 고품질의 3D 기하학을 생성하는 expressive hybrid explicit-implicit network architecture를 소개합니다. decoupling feature generation과 neural rendering을 분리함으로써 우리의 프레임워크는 StyleGAN2와 같은 state-of-the-art 2D CNN generators를 활용하고 효율성과 표현력을 계승할 수 있습니다. 우리는 다른 실험 중 FFHQ 및 AFHQ 고양이와 함께 최첨단 3D 인식 합성을 보여줍니다.

Introduction

GAN(Generative Adversarial Networks)은 최근 몇 년간 주요 이슈 중 하나였습니다.

유명한 Generator-Discriminator Mechanism을 기반으로 하는 매우 간단한 기능으로 인해 이전 architecture를 지속적으로 개선하기 위한 연구가 주도되었습니다. 사람도 속일 수 있는 매우 사실적이고 고품질의 이미지를 생성할 수 있는 StyleGAN은 이미지 생성의 정점에 도달했습니다.

새로운 샘플을 생성하는 것이 2D 영역에서 우수한 결과를 얻었지만 3D GAN은 여전히 매우 비효율적이었습니다. 2D GAN의 정확한 메커니즘을 3D 환경에 적용하면 3D 데이터는 현재 GPU에서 조작하기 어렵기 때문에 계산량이 매우 높았습니다. 이러한 이유로 연구에서는 2D 이미지만 사용하여 underline 3D property을 유추할 수 있는 Geometry-aware GAN을 구성하는 방법에 중점을 두었습니다. 그러나 이 경우 근사값이므로 일반적으로 3D와 일치하지 않았습니다.

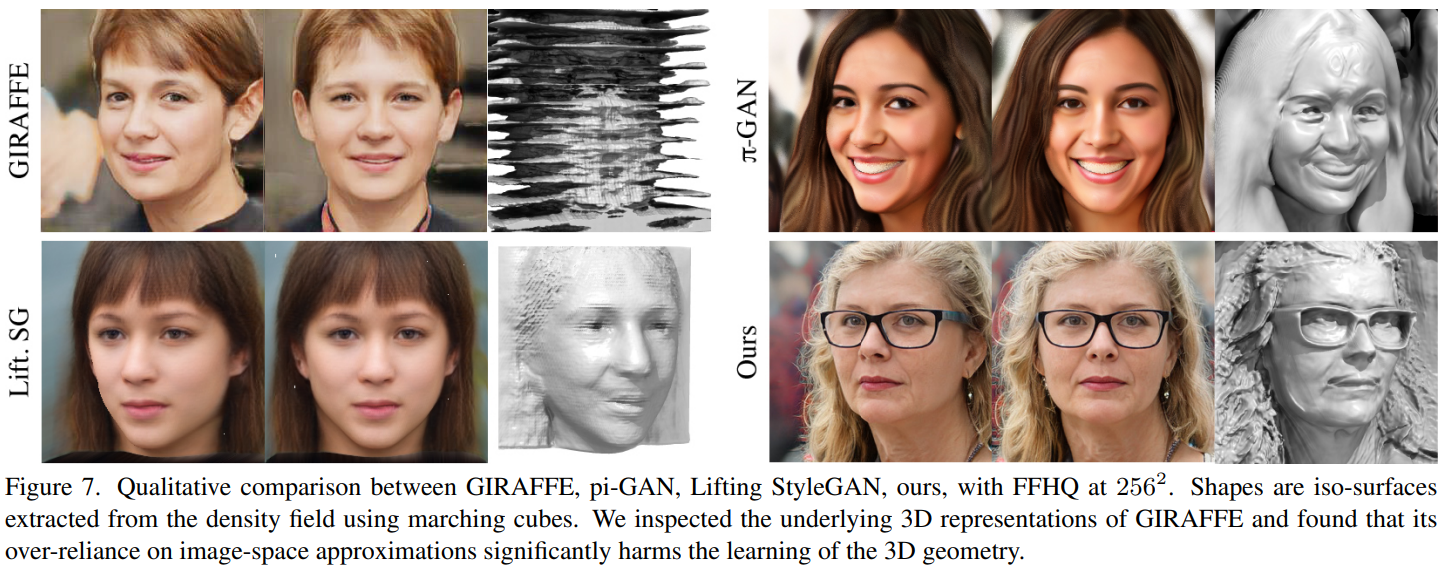

NVIDIA 팀은 Stanford University와 함께 이 문제를 해결하기 위해 효율적인 Geometry-aware 3D GAN을 제안했습니다. 이 Architecture는 고해상도 multi-view-consistent 2D 이미지를 합성할 수 있을 뿐만 아니라 고품질 3D 형상을 생성할 수 있습니다. 이것은 두 가지 주요 도입으로 달성되었습니다. 첫 번째는 효율적이고 표현력이 뛰어난 3면이라고 하는 hybrid explicit-implicit 3D representation입니다. 두 번째는 dual-discrimination strategy의 앙상블과 pose-based conditioning of the generator로 multi-view consistency을 촉진합니다.

Tri-plane 3D representation

3D 장면에서 특정 점을 선택하면 그 위치(x,y,z 좌표)와 방향(the point of view)으로 정의할 수 있습니다. 3D representation은 이 두 값을 입력으로 받아 RGB color과 density를 반환합니다(3D 장면을 통과하는 광선을 이미지화하는 경우 특정 지점의 밀도는 광선이 그곳에서 멈췄을 확률입니다. 예를 들어 다음과 같은 경우 점이 Solid 내부에 있으면 밀도가 높음).

3D representation은 각각 Voxel 및 NeRF 표현과 같이 명시적이거나 암시적일 수 있습니다. Discrete Voxel Grid와 같은 explicit representation은 예측이 빠르지만 explicit representation을 메모리(즉, 아래 그림 (b)의 Cube)에 유지해야 하므로 메모리가 매우 무겁습니다. 그렇지 않으면 implicit representations 은 장면을 연속 함수로 나타냅니다. 따라서 아래 그림 (a)의 (상대적으로) 큰 Decoder에서 볼 수 있듯이 메모리 효율적이지만 비용이 많이 드는 prediction이 있습니다.

Tri-plane representation은 implicit-explicit representation을 정의하는 두 가지 접근 방식의 장점을 가집니다. 전체 Voxel grid가 아닌 N x N x C (C는 1이 아니므로 위 이미지에서 잘못 추론할 수 있음)의 해상도로 메모리에 3개의 평면을 저장합니다. 3D 위치가 평면에 투영되고 해당 특징 벡터가 합산되어 작은 Decoder로 전달됩니다. Tri-plane representation은 예측과 메모리 효율성이 모두 빠르며 표현력도 아래 그림에서 다른 두 가지 접근 방식과 비교하여 입증되었습니다.

3D GAN framework

전체 프레임워크를 제시하기 전에 저자는 논문에서 알고리즘이 2D 이미지에서만 작동한다고 종종 지적하지만 각 이미지는 포즈 감지기를 사용하여 결정된 카메라 고유 및 외부 세트와 연관되어 있다는 점에 유의해야 합니다. 위 이미지의 P).

첫째, 임의의 잠재 코드와 방금 언급한 카메라 매개변수는 StyleGAN2 생성기와 후속 초해상도 모듈을 변조하는 데 사용되는 중간 잠재 코드를 반환하는 매핑 네트워크에 의해 처리됩니다. 다음 생성기는 256 x 256 x 96 이미지를 생성하고 채널별로 분할하여 3면 기능을 형성합니다. 3축 기능은 신경 렌더러에서 집계되고 경량 디코더는 주어진 카메라 포즈에서 128 x 128 x 32 이미지 If를 생성합니다.

전체 프로세스는 여전히 고해상도로 렌더링하기에는 너무 느립니다. 이러한 이유로 저자는 상대적으로 낮은 해상도로 렌더링하고 초고해상도 모듈로 업샘플링을 수행했습니다.

마지막으로 판별자는 렌더링을 평가하는 데 사용되지만 원래 StyleGAN2와 비교하여 두 가지 수정 사항이 있습니다. 먼저 다음 절차로 구성된 이중 식별이 사용되었습니다. If가 초해상도 모듈로 전달되어 512 x 512 x 3 이미지 Irgb+를 출력합니다. 동시에 If의 처음 세 채널은 저해상도 RGB 이미지 Irgb로 해석되며, 이 이미지는 512 x 512 x 3으로 이중 선형으로 샘플링되지 않고 Irgb+와 연결되어 6채널 이미지를 형성합니다. 이 프로세스는 초해상도 이미지가 신경 렌더링과 일치하도록 권장합니다.

둘째, 작성자는 Generator 가 올바른 3D 사전을 학습하는 데 도움이 되도록 생성된 이미지가 렌더링되는 카메라 포즈로 Discriminator 를 조건화했습니다.

Results

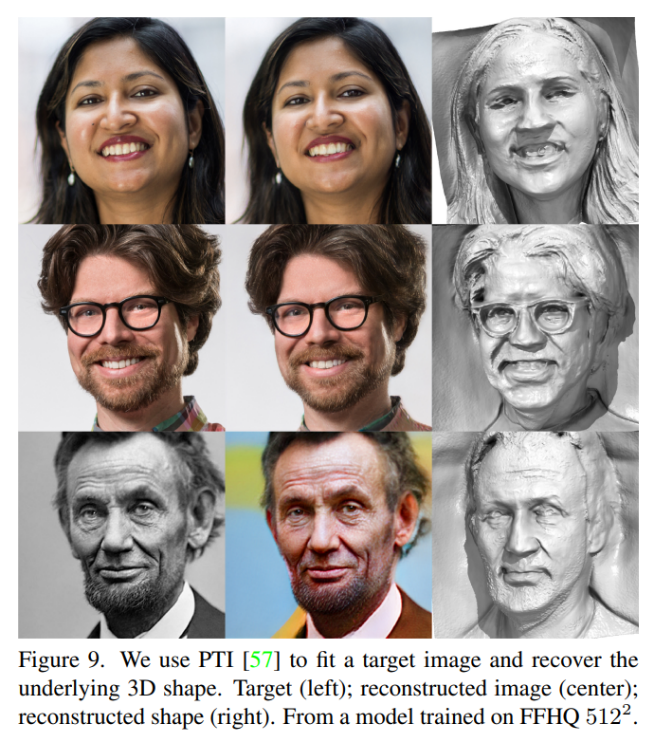

흥미롭게도 저자는 테스트 이미지를 맞추고 RGB 이미지(아래 이미지)에서 3D reconstruction을 얻기 위해 pivotal tuning inversion을 사용하여 single-view 3D reconstruction도 테스트했습니다.

저자가 지적했듯이 이 접근 방식은 여전히 미세한 details(예: 개별 치아)이 부족하지만 3D-aware GAN 분야에서 매우 중요한 개선점을 제공합니다.

'Artificial Intelligence > Computer Vision' 카테고리의 다른 글

| A Visual Guide to Vision Transformers (0) | 2024.04.30 |

|---|---|

| 이미지 화질 개선 AI 기술 (0) | 2024.02.23 |

| CVPR 2022 Tutorial on Neural Fields in Computer Vision (0) | 2022.09.15 |

| Meta Learning in Computer Vision 내용 정리 (0) | 2022.02.07 |

| A Normalized Gaussian Wasserstein Distance for Tiny Object Detection (0) | 2022.01.17 |